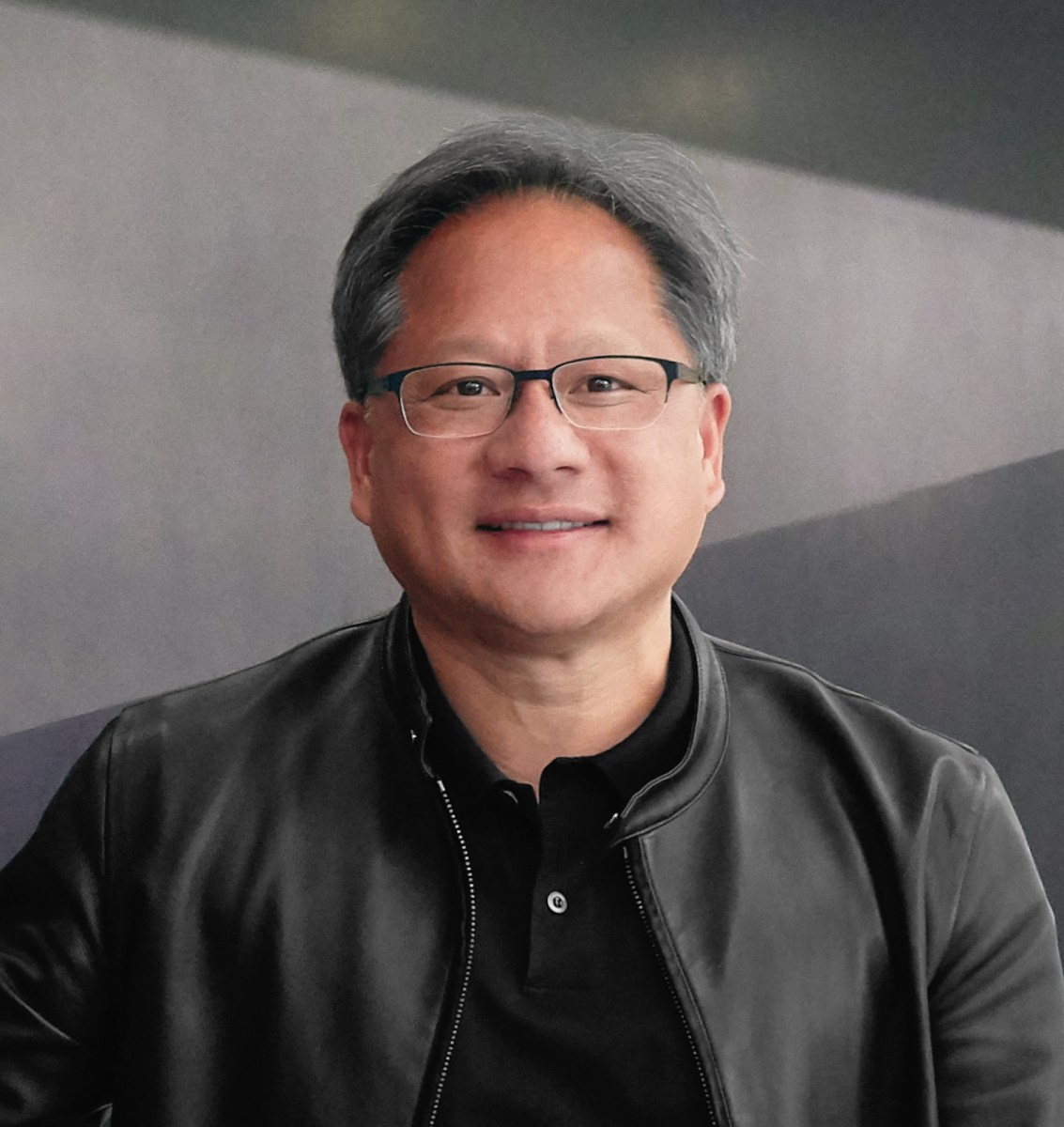

Jensen Huang will Um generative KI in jedes Rechenzentrum zu bringen, ist die NVIDIA sagte der Mitbegründer und CEO heute während der Computex in Taipeh. Während der Rede, Hwangs erster öffentlicher Rede seit fast vier Jahren, sagte er, er habe eine Reihe von Ankündigungen gemacht, darunter Chip-Veröffentlichungstermine, den Supercomputer DGX GH200 und Partnerschaften mit großen Unternehmen. Hier finden Sie alle Neuigkeiten der zweistündigen Keynote.

1. Nvidias GForce RTX 4080 Ti GPU für Gamer ist jetzt in voller Produktion und wird gemeinsam mit Partnern in Taiwan in „Massenproduktion“ hergestellt.

2. Huang kündigte die Nvidia Avatar Cloud Engine (ACE) für Spiele an, einen anpassbaren KI-Modell-Foundry-Service mit vorab trainierten Modellen für Spieleentwickler. NPCs werden durch KI-gestützte Sprachinteraktionen mehr Persönlichkeit verliehen.

3. Das Nvidia Cuda-Computing-Modell bedient mittlerweile vier Millionen Entwickler und mehr als 3.000 Apps. Cuda verzeichnete 40 Millionen Downloads, davon 25 Millionen allein im letzten Jahr.

4. Die vollständige Produktion der HGX H100-Server-GPU hat begonnen und wird von „Unternehmen in ganz Taiwan“ hergestellt, sagte Huang. Er fügte hinzu, dass es der erste Computer der Welt mit einer Transformator-Engine sei.

5. Huang bezeichnete Nvidias Übernahme des Computerchip-Riesen Mellanox im Jahr 2019 für 6,9 Milliarden US-Dollar als „eine der größten strategischen Entscheidungen“, die das Unternehmen je getroffen hat.

6. Die Produktion der nächsten Generation der Hopper-GPUs beginnt im August 2024, genau zwei Jahre nach Produktionsbeginn der ersten Generation.

7. Nvidias GH200 Grace Hopper ist jetzt in voller Produktion. Der Superchip verfügt über 4 PetaFIOPS TE, 72 ARM-CPUs, die über eine Chip-zu-Chip-Verbindung verbunden sind, 96 GB HBM3-Speicher und 576 GPUs. Huang beschrieb ihn als den weltweit ersten Prozessor für beschleunigtes Rechnen, der auch über einen riesigen Speicher verfügt: „Das ist ein Computer, kein Chip.“ Es ist für hochflexible Rechenzentrumsanwendungen konzipiert.

8. Wenn der Speicher des Grace Hopper nicht ausreicht, hat Nvidia die Lösung – die DGX GH200. Es wurde erstellt, indem zunächst acht Grace Hoppers mit drei NVLINK-Adaptern verbunden wurden und dann die beiden 900-GB-Pods miteinander verbunden wurden. Dann wurden schließlich 32 Chips mit einer weiteren Schlüsselschicht aneinandergereiht, um insgesamt 256 Grace Hopper-Chips zu verbinden. Der resultierende ExaFLOPS Transformer verfügt über 144 TB GPU-Speicher und fungiert als riesige GPU. Huang sagte, der Grace Hopper sei so schnell, dass er den 5G-Stack in der Software ausführen könne. Google Cloud, Meta und Microsoft werden die ersten Unternehmen sein, die Zugang zum DGX GH200 haben und dessen Fähigkeiten erforschen werden.

9. Nvidia und SoftBank haben sich zusammengetan, um den Grace Hopper-Superchip an die neuen verteilten Rechenzentren von SoftBank in Japan zu liefern. Sie werden in der Lage sein, generative KI- und drahtlose Anwendungen in einem gemeinsamen mandantenfähigen Serversystem zu hosten und so Kosten und Energie zu reduzieren.

10. Die SoftBank-Nvidia-Partnerschaft basiert auf der Nvidia MGX-Referenzarchitektur, die derzeit in Partnerschaft mit Unternehmen in Taiwan verwendet wird. Es bietet Systemherstellern eine Standard-Referenzarchitektur, die ihnen beim Aufbau von mehr als 100 Servervarianten für KI, beschleunigtes Computing und allgegenwärtige Dienstprogramme hilft. Zu den an der Partnerschaft beteiligten Unternehmen gehören ASRock Rack, Asus, Gigabyte, Pegatron, QCT und Supermicro.

11. Huang kündigt die beschleunigte Netzwerkplattform Spectrum-X zum Übertakten von Ethernet-basierten Clouds an. Enthält einen Spectrum 4-Switch mit 128 Ports mit 400 Gbit/s und 51,2 Tbit/s. Der Switch sei darauf ausgelegt, eine neue Art von Ethernet zu ermöglichen, sagte Huang, und sei durchgängig für adaptives Routing, Leistungsisolation und Rechenleistung innerhalb der Fabric konzipiert. Es enthält außerdem einen Bluefield 3 Smart Nic, der an einen Spectrum 4-Switch angeschlossen wird, um die Menschenmengenkontrolle durchzuführen.

12. WPP, die weltweit größte Werbeagentur, hat sich mit Nvidia zusammengetan, um eine Content-Engine auf Basis des Nvidia Omniverse zu entwickeln. Es wird in der Lage sein, Foto- und Videoinhalte für den Einsatz in der Werbung zu produzieren.

13. Die Nvidia Isaac ARM-Roboterplattform ist jetzt für jeden verfügbar, der Roboter bauen möchte, und sie ist alles in einem, vom Chip bis zum Sensor. Huang sagte, Isaac ARM beginne mit einem Chip namens Nova Orin, der die erste vollständige Robotik-Referenzbaugruppe sei.

Dank seiner Bedeutung im KI-Computing sind die Nvidia-Aktien im vergangenen Jahr stark gestiegen, und die Marktkapitalisierung liegt derzeit bei rund 960 Milliarden US-Dollar, was das Unternehmen zu einem der wertvollsten Unternehmen der Welt macht (nur Apple, Microsoft, Saudi Aramco, Alphabet usw.). Amazon-Rang höher).

Geschäft in China in der Schwebe

Es besteht kein Zweifel daran, dass KI-Unternehmen in China die neueste Siliziumtechnologie, die Nvidia auf den Markt bringt, genau im Auge behalten. In der Zwischenzeit befürchten sie möglicherweise eine weitere Runde von Chip-Verboten in den USA, die ihre Fortschritte bei der generativen KI zu untergraben drohen, die weitaus mehr Strom und Daten erfordert als frühere KI-Generationen.

Im vergangenen Jahr verbot die US-Regierung Nvidia den Verkauf von A100- und H100-GPUs an China. Beide Chips werden zum Trainieren großer Sprachmodelle wie GPT-4 von OpenAI verwendet. Besonders stark nachgefragt wird der H100, sein Chipsatz der neuesten Generation, der auf der Nvidia Hopper GPU-Computing-Architektur mit integrierter Transformer Engine basiert. im Vergleich zum A100H100 ist in der Lage, ein 9-mal schnelleres KI-Training und eine bis zu 30-mal schnellere KI-Inferenz auf LLMs bereitzustellen.

China ist eindeutig ein zu großer Markt, um ihn zu verpassen. Das Chip-Exportverbot würde Nvidia allein im dritten Quartal des vergangenen Jahres schätzungsweise 400 Millionen US-Dollar an potenziellen Umsätzen kosten. Daher hat Nvidia darauf zurückgegriffen, China einen langsameren Chip zu verkaufen, der den US-Exportkontrollbestimmungen entsprach. Aber auf lange Sicht wird China wahrscheinlich nach leistungsfähigeren Alternativen suchen, und das Verbot ist eine eindringliche Mahnung für China, in wichtigen Technologiesektoren Eigenständigkeit zu erlangen.

Wie Huang kürzlich sagte Interview Mit der Financial Times: „Wenn [China] Sie können nicht in den USA kaufen, sie werden es selbst bauen. Die Vereinigten Staaten sollten also vorsichtig sein. China ist ein sehr wichtiger Markt für die Technologiebranche.“

„Pop-Kulturaholic. Web-Nerd. Engagierter Social-Media-Praktiker. Reisefanatiker. Schöpfer. Food-Guru.“

More Stories

Brightline West hat den Grundstein gelegt. Geplante Passagierzahlen für 2028

Die Tesla-Aktie befindet sich nach einem Rückgang der Vorgewinne um 43 % im „Niemandsland“.

Der Bau der ersten Hochgeschwindigkeitsstrecke Amerikas beginnt